¿Qué es el crawl budget y cómo mejorarlo?

El crawl budget (o frecuencia de rastreo) consiste en el periodo de tiempo que pasa el robot de Google (el más conocido es Googlebot) en un sitio web y con qué asiduidad lo visita.

Cuando hablamos de Googlebot estamos hablando de una de las arañas o robots de Google que se encargan de visitar los sitios web que forman su índice en busca de información y siguen los enlaces que componen cada una de sus páginas, simulando a cualquier humano que podría visitar ese sitio web.

¿Cuánto tiempo de rastreo le pertenece a cada página web?

Si estabas pensando en que a cada sitio web le pertenece el mismo tiempo de rastreo, te equivocas, Google cataloga cada una de las páginas de su índice con un baremo en las que las evalúa en función de las características que considera adecuadas. Ese baremo hace que se proporcione un valor a cada página, es el llamado PageRank; en el caso de la frecuencia de rastreo también se cataloga a cada sitio web.

De esta forma este motor de búsqueda asigna un tiempo en el cual, la araña permanecerá explorando el sitio web en cuestión, descubriéndolo por primera vez o volviendo a recorrerlo en búsqueda de nueva información o de cambios.

Es importante tener en cuenta que si el sitio web muestra información nueva en plazos de tiempo cortos, el buscador puede asignar una mayor cantidad de tiempo al robot para que rastree ese sitio web y volverá a visitarlo con una menor frecuencia.

¿Debe preocuparse al igual por la frecuencia de rastreo un sitio grande que uno pequeño?

Aquí mencionaremos el eterno “depende”, y aunque no exista una verdad absoluta me voy a atrever a dar una opinión personal, el crawl budget no es un factor tan importante en un sitio web pequeño como en uno grande. Es más mi punto de vista en particular se centra en que si tienes un sitio web pequeño, tienes bastantes factores que considerar más prioritarios en la estrategia SEO, que focalizarse en ese punto en primer lugar.

Lo que sí debemos tratar de intentar hacer siempre con independencia del tamaño del sitio, es que Googlebot escanee en primer lugar las páginas que nos resultan más interesantes y no se centre en otras que no lo son tanto, con ello conseguimos aprovechar en mayor medida ese tiempo limitado que pasa la araña en nuestro sitio web y en esos casos sí obtendremos un beneficio muy notable.

¿En que puede beneficiar a una web optimizar el crawl budget?

El principal beneficio obtenido es que facilitamos en gran medida la indexación de las páginas web que componen nuestro site.

¿Cómo podemos optimizar el tiempo que pasa ese robot en nuestro sitio web?

Si queremos que cuando Google este visitando nuestro sitio web, no se pierda por lugares que carecen de interés, debemos ayudarle a encontrar el camino adecuado. Esto lo conseguimos si no poseemos demasiadas páginas con errores o excesivas redirecciones en el site. Además como se ha comentado anteriormente, si ofrecemos de forma continua nuevo contenido de calidad, los robots entenderán que necesitan dedicar una mayor cantidad de tiempo a ese sitio web.

Otro punto importante es mostrar la información que se nos solicita de una forma rápida. De esta forma el tiempo se aprovechará en mayor media que si respondemos facilitando la información en un tiempo lento.

Además desde el archivo robots.txt podemos bloquear páginas que no nos interesa sean visitadas.

¿Afecta de alguna manera a mis visitantes que estos robots recorran mi sitio web?

No, el que un sitio web esté siendo rastreado por una de estas arañas no afectará en la experiencia de usuario de los visitantes.

¿Podemos limitar la frecuencia de rastreo a nuestro sitio web?

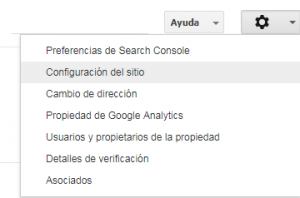

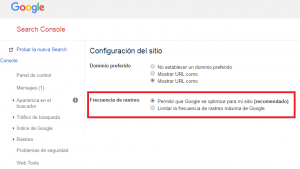

Si, podemos limitar la frecuencia de rastreo a nuestro sitio web de una forma muy sencilla desde Search Console, esto lo podemos hacer desde:

Esta opción ya se encuentra disponible desde la antigua herramienta, antes de producirse la reciente actualización que ha desembocado en la nueva Search Console.

Conclusiones

Como conclusión principal cabe destacar que el crawl budget es un punto imprescindible a trabajar en sitios web que contengan un contenido razonable o grande y también se debe optimizar en sitios más pequeños aunque la prioridad puede ser algo menor.

Otra de las conclusiones principales consiste en que el tiempo que pasa el robot en nuestro sitio web se encuentra limitado y debemos de facilitarle en la medida de lo posible la información que consideremos más relevante de nuestro site, evitando contenido no tan prioritario.

Como tercer punto a destacar me gustaría indicar que el que nuestro site posea una gran cantidad de errores (4xx), redirecciones (3xx) o contenido de baja calidad no solo perjudicará a la frecuencia de rastreo si no a muchos otros aspectos.

Una buena recomendación final es que visites las directrices de Google respecto a la frecuencia de rastreo.

ARTÍCULOS RELACIONADOS

Hola! Soy Consultor SEO en Internet República, apasionado del marketing digital y en constante actualización.