Archivos robots.txt originales y curiosos

El archivo robots.txt se incluye dentro de la raíz de la web y sirve para indicar a los motores de búsqueda las pautas de rastreo que deben seguir, permitiendo y bloqueando el acceso a determinadas partes de la web. Pero, ¿sirven para algo más?

Algunas páginas utilizan el archivo robots para incluir mensajes curiosos, promocionales o incluso para búsqueda de talentos SEO.

Os dejamos aquí una recopilación de los archivos robots.txt más curiosos.

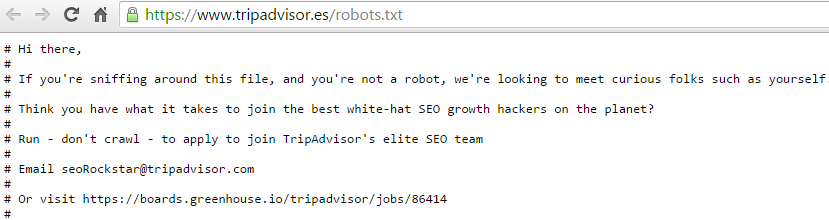

Búsqueda de talento SEO en robots.txt:

Algunas páginas saben lo importante que es el archivo robots en SEO, por eso utilizan este archivo para captar a los mejores candidatos de SEO que por voluntad propia hayan buscado o revisado este archivo en sus páginas.

Uno de los ejemplos de este tipo de reclutamiento lo realiza el robots.txt de TripAdvisor:

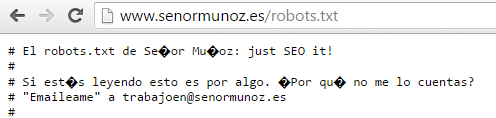

Otra de las páginas que utiliza este tipo de técnica es la agencia de SEO de Señor Muñoz:

“Si estás leyendo esto es por algo. ¿Por qué no me lo cuentas?”

Además de este mensaje podéis leer otros bastante curiosos en su archivo http://www.senormunoz.es/robots.txt

Publicidad en los robots.txt:

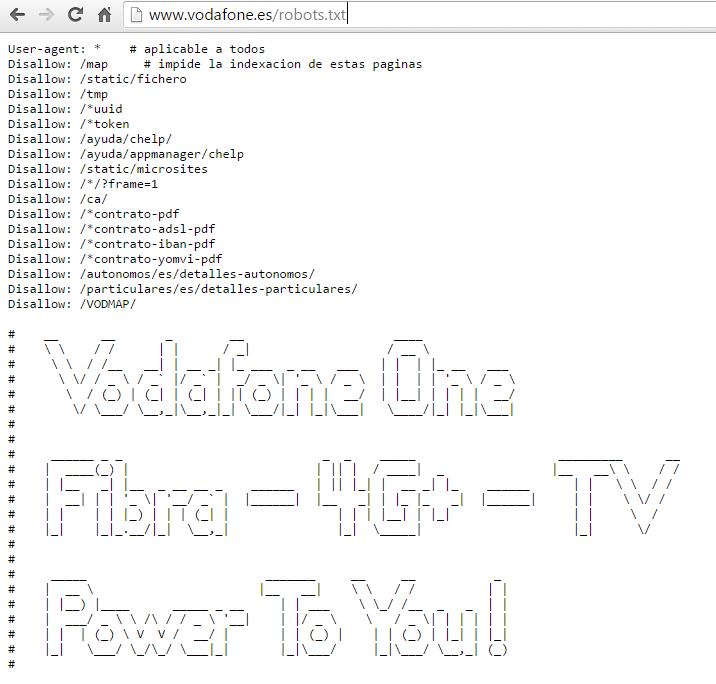

También podemos encontrar mensajes publicitarios o referencias a la marca en el archivo robots. Este es el caso de www.vodafone.es que utiliza su archivo para mostrar un mensaje publicitario:

http://www.vodafone.es/robots.txt

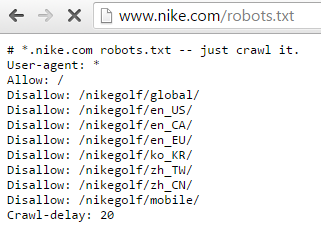

Nike también incluye un slogan referente a la marca haciendo un simil con su conocido “Just do it”

Bloqueando información curiosa en robots.txt:

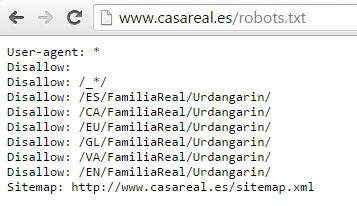

Uno de los robots.txt más conocidos corresponde a la página de la Casa Real española, que tras las acusaciones de Iñaki Urdangarin bloquearon en el archivo todo lo relacionado con él dentro de la página, algo que fue bastante comentado en el sector SEO. A día de hoy siguen bloqueando este contenido. Podéis verlo en http://www.casareal.es/robots.txt

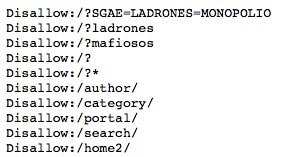

La SGAE también hizo de las suyas bloqueando contenido que no le interesaba. En este caso se encargaron de bloquear todo lo que les relacionaba con las palabras ladrones, mafiosos o monopolio.

Archivos importantes en robots.txt:

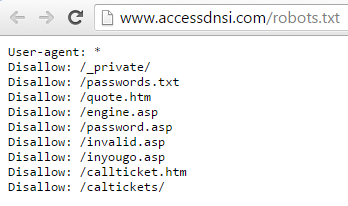

Una práctica muy conocida es bloquear aquellos archivos que son importantes para la página sin cambiarles el “llamativo nombre”. Ocurre con páginas como accessdnsi.com en las que podéis ver que se bloquea el archivo /passwords.txt. Aunque mejor entráis y lo veis.

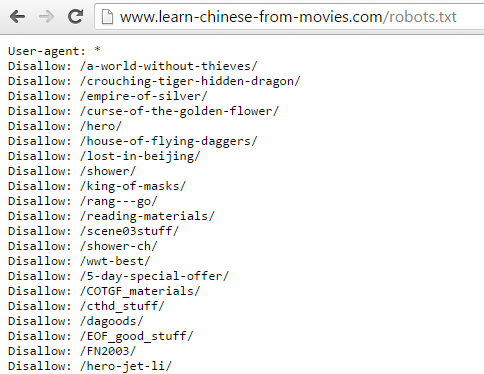

Otra metedura de pata de esta magnitud la provocó una página china de compra de subtítulos para películas y series que cobraba unos 25 euros por subtitulo. Solo que no se acordó de cambiar el nombre de los archivos bloqueados en el robots.

Robots.txt curiosos:

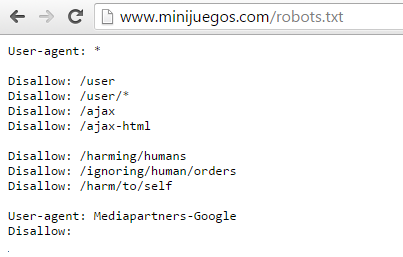

Otras páginas utilizan el archivo para incluir curiosidades y llamar la atención de los usuarios en sus archivos robots.txt . Es el caso de páginas como www.last.fm/robots.txt o www.minijuegos.com/robots.txt que utilizan su robots para hacer una alusión a las tres leyes de la robótica de Isaac Asimov.

Se comenta también que Google antes de lanzar un producto al mercado lo bloquea en el archivo robots. De hecho, muchos fans revisan periódicamente el archivo robots de Google.com/robots.txt para encontrar nuevos lanzamientos.

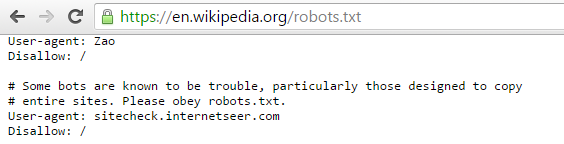

La wikipedia es otra página que incluye en su archivo robots mensajes curiosos para los usuarios. Aquí se quejan de que todo el mundo les copia.

El archivo robots de la página de nuestro colega SEO Lino Uruñuela, en su página mecagoenlos.com también muestra comentarios curiosos y hasta un pequeño robot dibujado en el archivo.

Otro archivo curioso es el propio de robots.txt al ser redundante de su propia página http://www.robotstxt.org/robots.txt

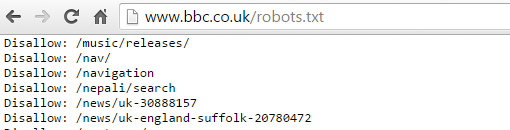

La BBC también utiliza el archivo robots para bloquear noticias que quiere mostrar pero no quiere que se indexen como www.bbc.co.uk/news/uk-england-suffolk-20780472

Y por último os vamos a hablar de una iniciativa de un grupo de españoles que crearon un archivo txt para humanos en los que aconsejan crear el archivo humans.txt donde incluir el nombre de los “humanos” que forman parte de la creación de las distintas webs. La intención es dar a conocer a las personas que forman parte de una determinada web y tienen alguna función en ella. De hecho, el propio Google incluyó este archivo en su dominio principal en el que indica que por la cantidad de personas que trabajan en Google, no les es posible incluir todos los nombres de sus empleados dejando este comentario:

“Google is built by a large team of engineers, designers, researchers, robots, and others in many different sites across the globe. It is updated continuously, and built with more tools and technologies than we can shake a stick at. If you’d like to help us out, see google.com/careers.”

Si conoces más archivos robots.txt curiosos, déjanos un comentario indicándonos la ruta y pon en marcha tu imaginación para crear un archivo robots original y divertido en tu propia página.

También te puede interesar:

ARTÍCULOS RELACIONADOS

Nací en Málaga y dicen que seseo.