Analiza tu contenido duplicado con SafeCont

Como ya sabemos, el contenido es uno de los pilares principales del SEO. Que tu web tenga un buen contenido es fundamental para mejorar el posicionamiento web. No debemos olvidar, que el contenido tiene que aportar valor al usuario y que Google penaliza el contenido duplicado. Es importante resaltar que Google considera contenido duplicado cuando existen páginas que tienen contenido muy parecido o casi idéntico aunque tengan URLs diferentes. Estas URLs pueden estar dentro de un mismo dominio, es decir, contenido duplicado internamente dentro de tu site; o diferentes dominios, con lo que estaríamos hablando de contenido duplicado externo.

Para realizar este análisis, so quiero presentar Safecont que en palabras de sus creadores, es la herramienta más avanzada de análisis SEO y calidad de contenido.

Safecont te ofrece una aproximación de la probabilidad de que tu dominio sea penalizado por los buscadores.

¿Cómo funciona SafeCont?

El funcionamiento es muy sencillo, sólo tienes que ingresar tu dominio, y lanzar el análisis. También puedes configurar algún parámetro para realizar una indexación lenta o que no se rastren ciertas partes de la web que no te interesan. Después hay que esperar a que el crawler de Safecont analice el site y cuando acabe, ver el análisis que te genera.

Informe de Safecont “Página Principal”

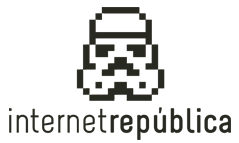

Al clicar en ver el análisis, la primera pantalla, te muestra un resumen del mismo, como puedes ver en la siguiente imagen:

Lo primero que ves, es la puntuación con la que Safecont considera que tu dominio puede ser penalizado por los motores de búsqueda, lo cual llama PandaRisk y califican textualmente “Puntuación que Safecont le otorga a una página/URL dentro del sitio web analizado en función del riesgo que corre de ser penalizada algorítmicamente por los motores de búsqueda. La puntuación oscila de 0 % a 100 %, cuanto más próximo al 100 más posibilidades de penalización. Los valores de peligro bajos aparecerán en color verde, los intermedios en amarillo y naranja y los más peligrosos en rojo. El PageRisk se calcula a partir de multitud de factores entre los que se encuentran la similitud interna, posibles problemas de thin content, duplicado externo, etc.”.

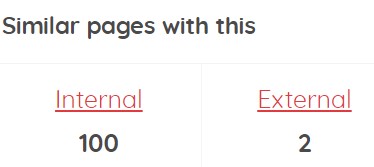

Después, te muestra el número de páginas que presentan problemas de thin content (páginas que tienen poco contenido), similaridad o contenido duplicado externo (si en el lanzamiento del análisis lo has configurado). Si pinchas sobre cada una, te va a la información detallada de las páginas que presentan esos problemas (también accedes a cualquier información de la pantalla principal, desde el menú superior). Para cada uno de esos problemas, te va a mostrar la información segmentada por porcentajes, para que puedas priorizar la información y al final te muestra la lista total. Una vez ahí debes clicar en el círculo rojo con un “+” para ver la información detallada de cada página. Dentro de esta información, es muy importante a ir a la información de la siguiente imagen, donde podrás ver qué paginas son similares internamente del site, así como su porcentaje de similitud y las páginas similares externas y su porcentaje.

A continuación, te muestra la información por clusters, agrupando las páginas, de 10 en 10 unidades, que tienen los tres problemas, así como el riesgo que representan. El funcionamiento es el mismo, clicar sobre cada uno, e ir analizando las distintas páginas haciendo clic en el círculo rojo con un un “+”.

Y finalmente, te muestra las páginas más peligrosas.

Como he comentado, cada uno de estos apartados de la página principal, tienen también acceso desde el menú superior en: Risks, Clusters, Similarity y External Duplicate.

Desde la pestaña “Pages” del menú superior puedes acceder a todas las páginas analizadas, así como los problemas que presentan cada una, es decir, tenemos un listado completo de todas las páginas.

Por último, es interesante el análisis de la pestaña “Análisis de Arquitectura” donde obtendrás un análisis de la arquitectura de la información de la web analizada, con la clasificación por niveles de profundidad, un gráfico con la autoridad del interlinkado del site, las páginas más potentes y los anchor text más populares.

Conclusión

En mi opinión, es una herramienta que nos da muchísima información valiosa, pero hay que analizarla bien, ya que elementos comunes que tengas en tu página, como el footer, siderbars, etc, te van a dar problemas de similitud, con lo que si esos contenidos son muy extensos, los porcentajes pueden ser muy altos, y no quiere decir, que el contenido, digamos real de la página, sea duplicado; además, no tiene en cuenta si ya tienes etiqueta canonical en las páginas que has detectado como duplicadas, con lo que debes filtrar esa información.